ChatGPT, чатботът, създаден от OpenAI след повече от десетилетие изследвания и технологичен напредък в областта на машинното обучение и изкуствения интелект, стартира на 30 ноември 2022г. и завладя света.

Не след дълго SEO оптимизаторите започнаха да мислят за начини за интегриране на мощната нова технология на изкуствения интелект в своите кампании на сайта и извън него.

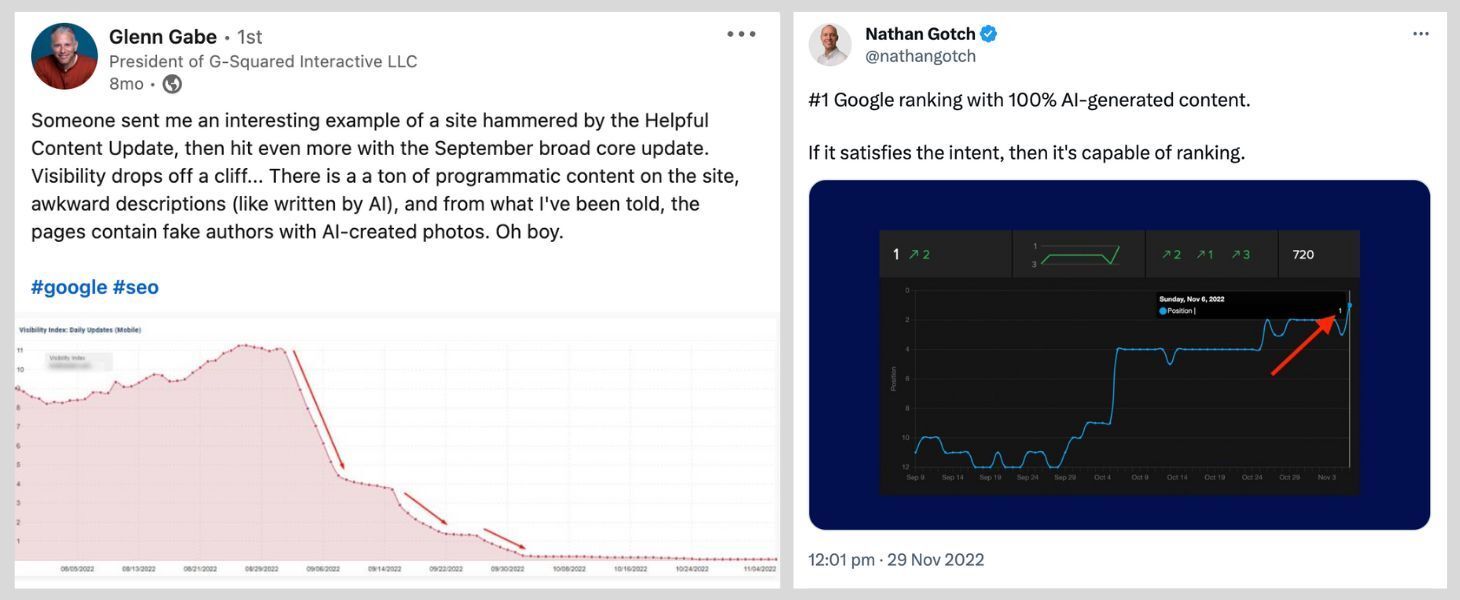

С толкова много SEO компании, които бързат да използват AI в своите кампании за съдържание на сайта и без никакви солидни тестове за това как се справя спрямо алтернативните подходи и стратегии, не е изненадващо, че видяхме безброй казуси, които показват както положителното, така и отрицателното въздействие на съдържанието, генерирано от AI, върху SEO:

По-горе е показано проучване на Глен Гейб, в което се подчертава отрицателното въздействие на съдържанието, генерирано от изкуствен интелект, и от Нейтън Готч, в което се подчертава положителното въздействие.

SEO оптимизацията е нюансирана и начинът, по който използвате изкуствения интелект, в крайна сметка ще бъде решаващият фактор за това дали той ще помогне или ще навреди на усилията ви за SEO оптимизация. Остава обаче въпросът дали Google ще класира по-добре или по-зле съдържанието, генерирано от ИИ, отколкото съдържанието, създадено от човек?

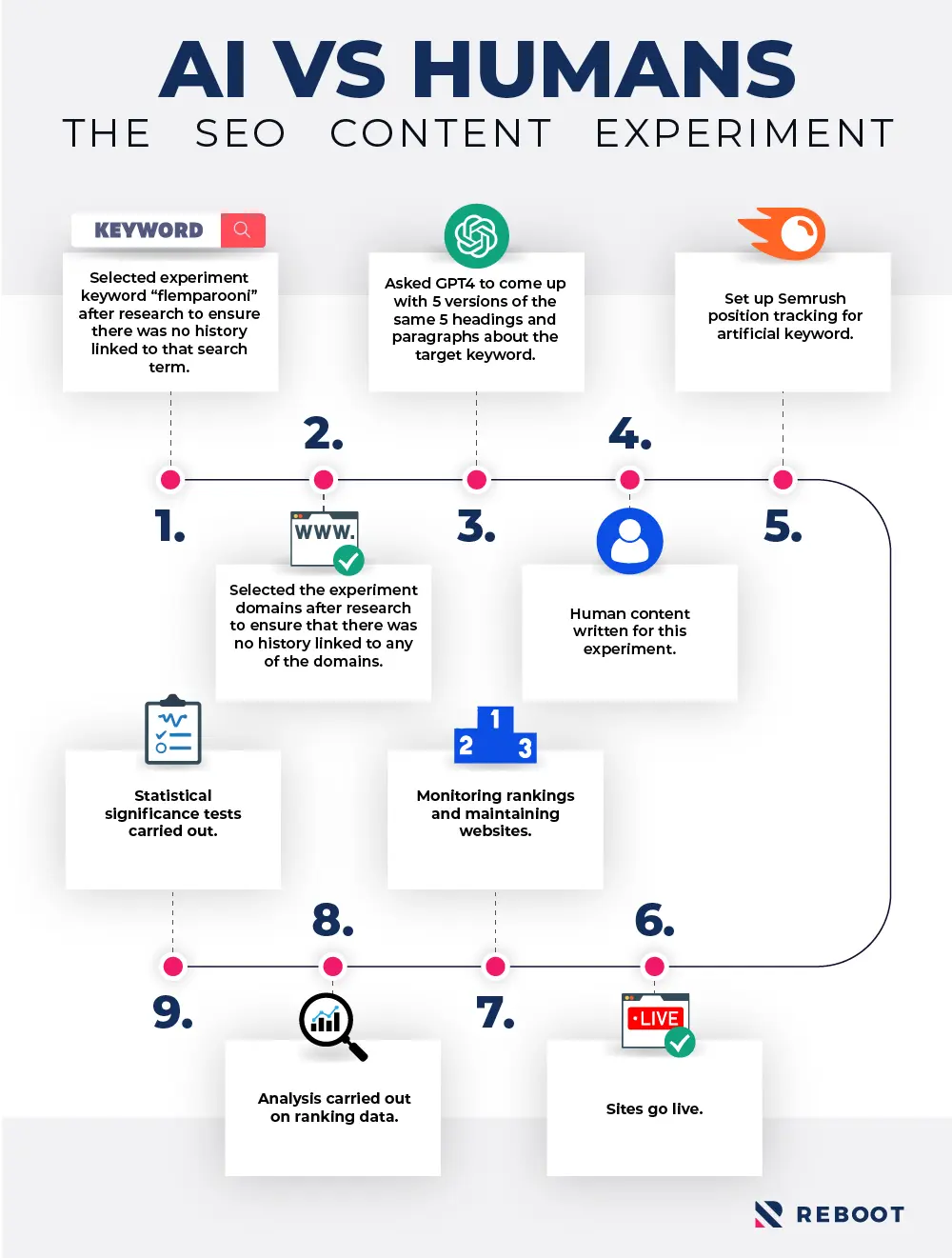

Прекарахме последните три месеца в създаването и провеждането на контролиран SEO експеримент, за да проверим дали при равни други условия на сайта и извън него има някакви разлики в класирането между двата вида съдържание.

Нека разгледаме нашата хипотеза, методологията, използвана за провеждането на този експеримент, и резултатите.

Хипотеза

Нашата хипотеза беше, че в контролирана среда без външни фактори, които да влияят върху възприеманото качество на даден уебсайт, съдържанието създадено от изкуствен интелект и човешкото съдържание ще се представят еднакво.

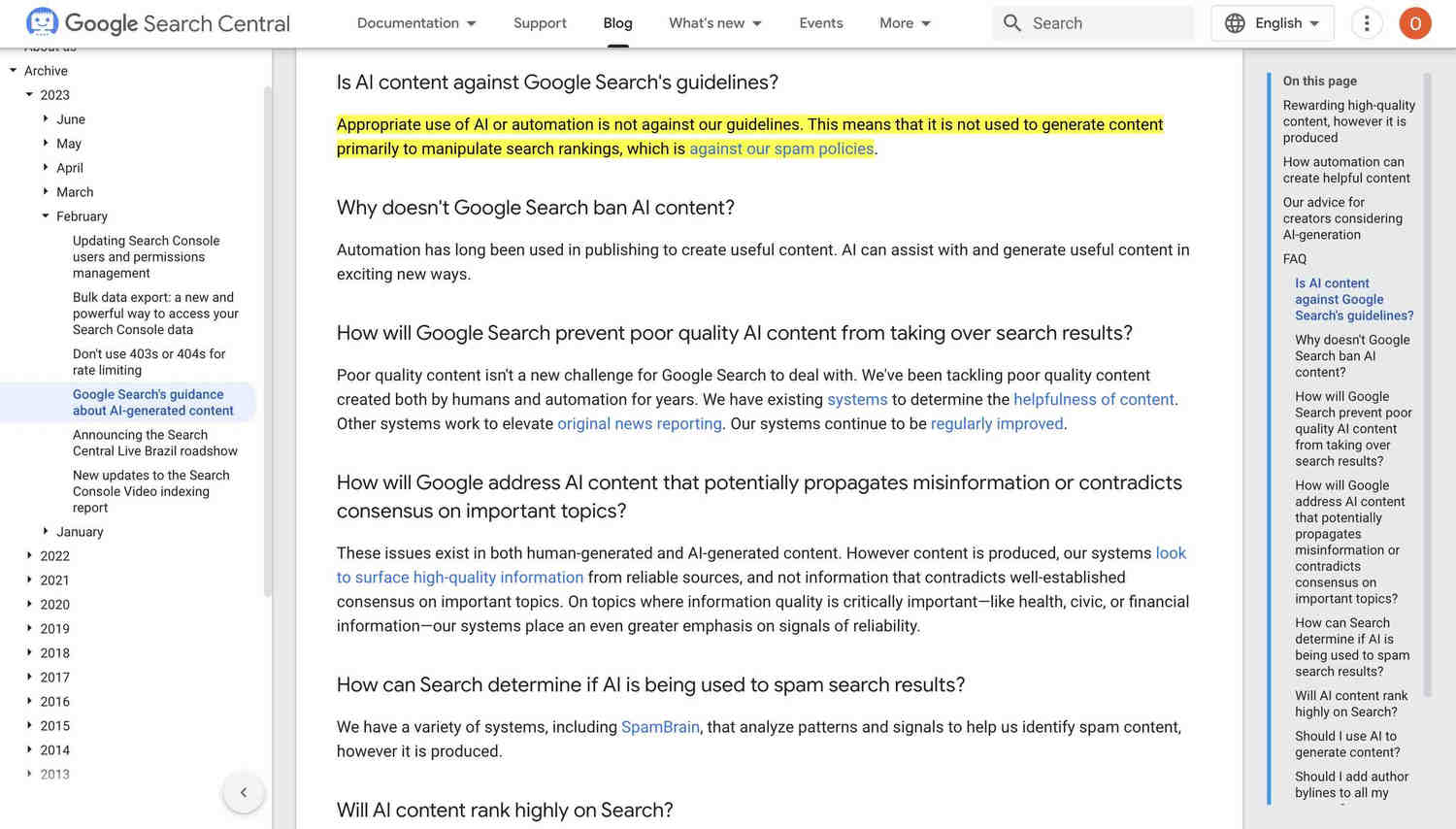

Не беше ясно, Google ще може да ли определи ,че даденото ново съдържание е генерирано от ИИ или е написано от човек. Освен това, тъй като използването на изкуствен интелект за генериране на съдържание само по себе си не противоречи на насоките на Google, не беше ясно дали използването на изкуствен интелект за генериране на съдържание ще повлияе по някакъв начин на класирането.

Документация на Google, която потвърждава, че използването на ИИ и автоматизация само по себе си не е в разрез с техните насоки.

От нашата хипотеза знаехме, че целта на експеримента ще бъде да се изолира използването на съдържание, генерирано от AI, като независима променлива.

Като изолирахме успешно използването на съдържание, генерирано от изкуствен интелект, като независима променлива, можехме да разберем какво влияние (ако има такова) оказва това върху класирането на тестовите домейни.

Методология

Както при всички наши SEO експерименти, първата стъпка в проверката на хипотезата беше планирането на цялостна методология, която ефективно да изолира други фактори за класиране, като същевременно ни позволи да проверим правилно нашата независима променлива.

По-долу сме разгледали подробно как точно изглеждаше нашата методология и всички фактори, които трябваше да вземем предвид при провеждането на експеримента.

Избор на тестова ключова дума

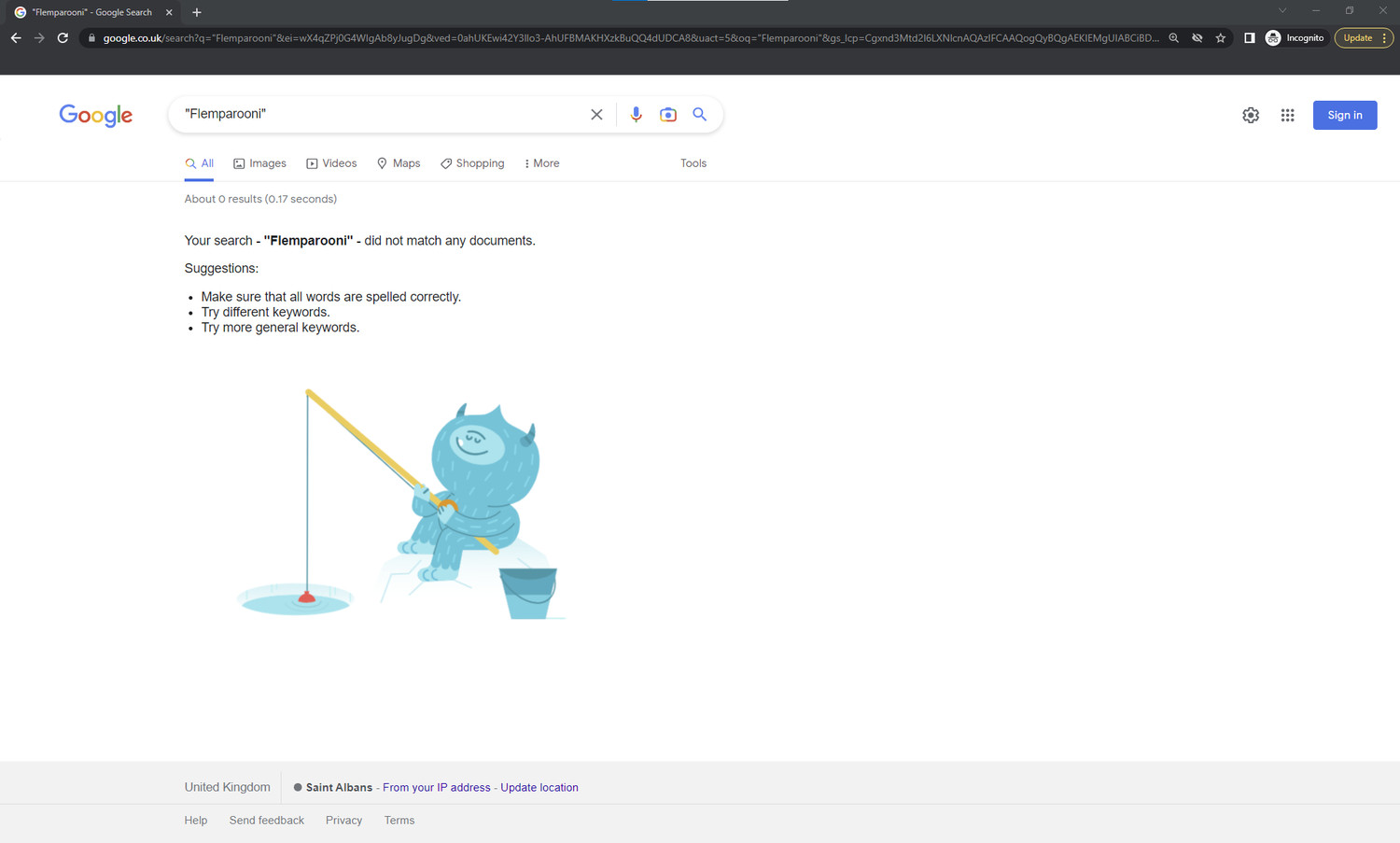

Търсенето в Google на нашата тестова ключова дума преди началото на експеримента не доведе до никакви резултати.

Знаехме, че насочването към реална тема и ключова дума в този експеримент би създало риск от въвеждане на външни фактори за класиране, които не можем да контролираме.

Например алгоритмите на Google могат да вземат предвид множество фактори като фактологичност на съдържанието спрямо друго публикувано съдържание по темата и/или стила на писане на други надеждни уебсайтове, обсъждащи темата, при определяне на мястото за класиране на нашите експериментални уебсайтове.

По тази причина решихме, че използването на изкуствена ключова дума ще бъде най-добрият подход.

Изкуствените ключови думи са термини за търсене, за които можем да потвърдим, че са неизвестни на Google преди нашия експеримент. Когато се търсят, те не връщат никакво съдържание в индекса на Google преди публикуването на нашите тестови уебсайтове.

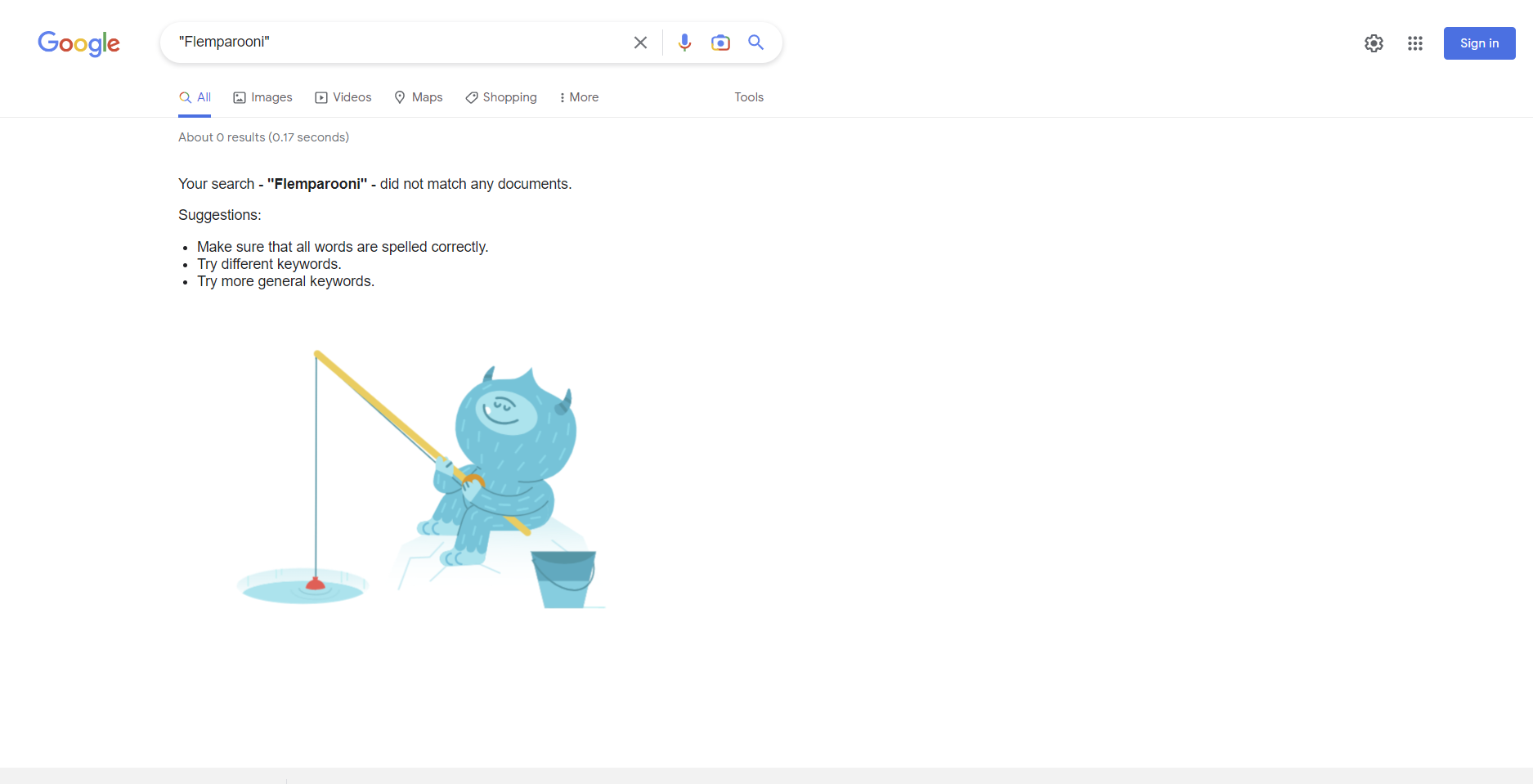

За щастие самият ChatGPT ни беше полезен при измислянето на изкуствената ключова дума за този експеримент.

Използвахме ChatGPT, за да измислим нашата тестова ключова дума.

Използвахме ChatGPT, за да измислим изкуствена ключова дума „flemparooni“, която след това проучихме, за да се уверим, че отговаря на критериите на нашия експеримент (т.е. не е била известна на Google преди началото на нашия тест).

Избор на тестови домейни

Трябваше да измислим имена на домейни за нашите тестови уебсайтове, които да отговарят на нашите критерии, за да премахнем риска от въздействие на фактори за класиране на ниво домейн върху резултатите от експеримента.

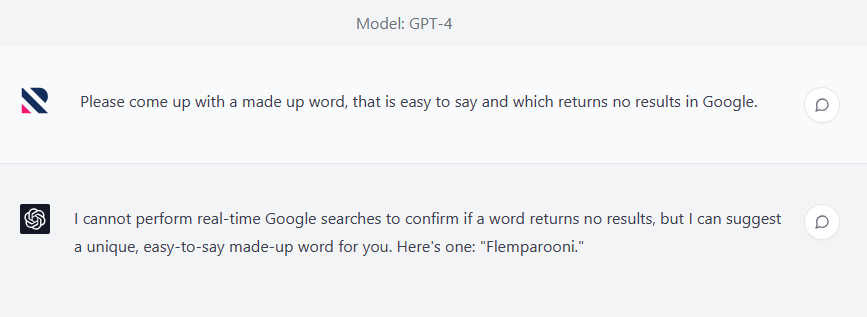

Отново използвахме ChatGPT, за да съставим начален списък с имена на домейни, в които се използват измислени думи.

Използвахме ChatGPT, за да съставим начален списък с експериментални домейни.

Изключихме един от тях, тъй като при търсенето му в индекса на Google той върна някои широки резултати от търсенето, и можете да видите на снимката на екрана по-горе, че в резултат на това поискахме от ChatGPT да ни даде друга идея за име на домейн.

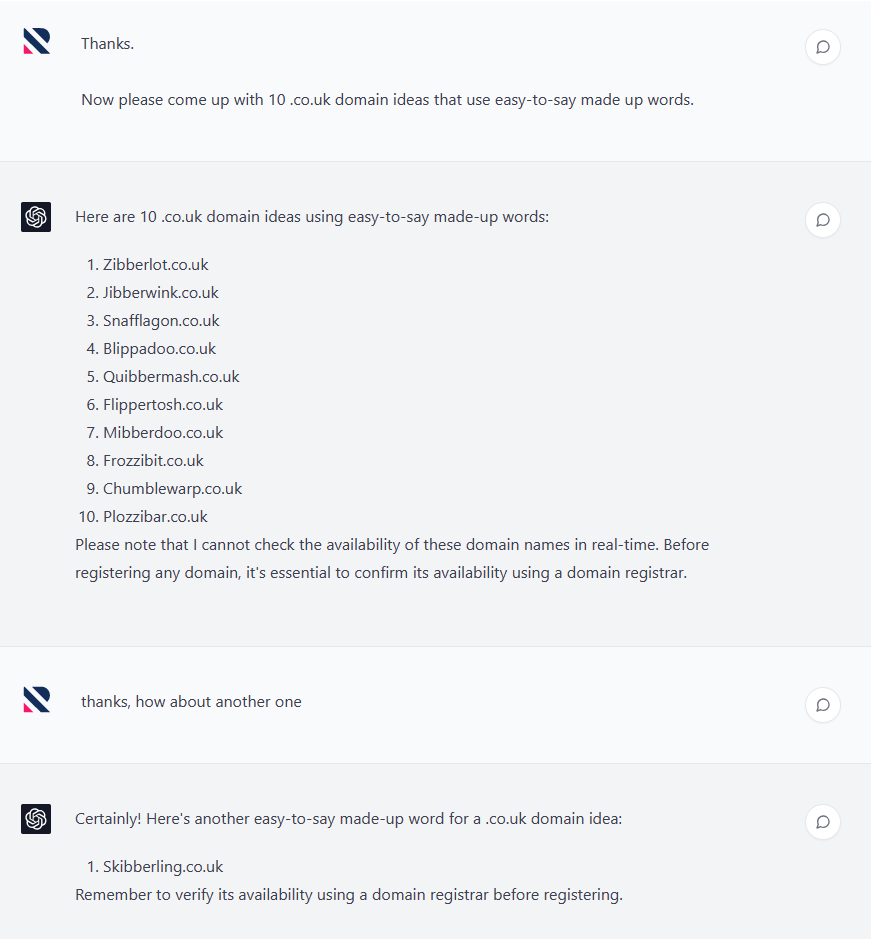

След като имахме под ръка нашия списък с начални домейни, проучихме всяко име на домейн, за да потвърдим, че избраните от нас домейни нямат свързани с тях „исторически сигнали“ за класиране.

Използвахме Archive.org, за да проверим дали на всеки домейн не е бил публикуван уебсайт преди това:

Използвахме Archive.org, за да потвърдим, че експерименталните ни домейни нямат никаква известна история, свързана с тях.

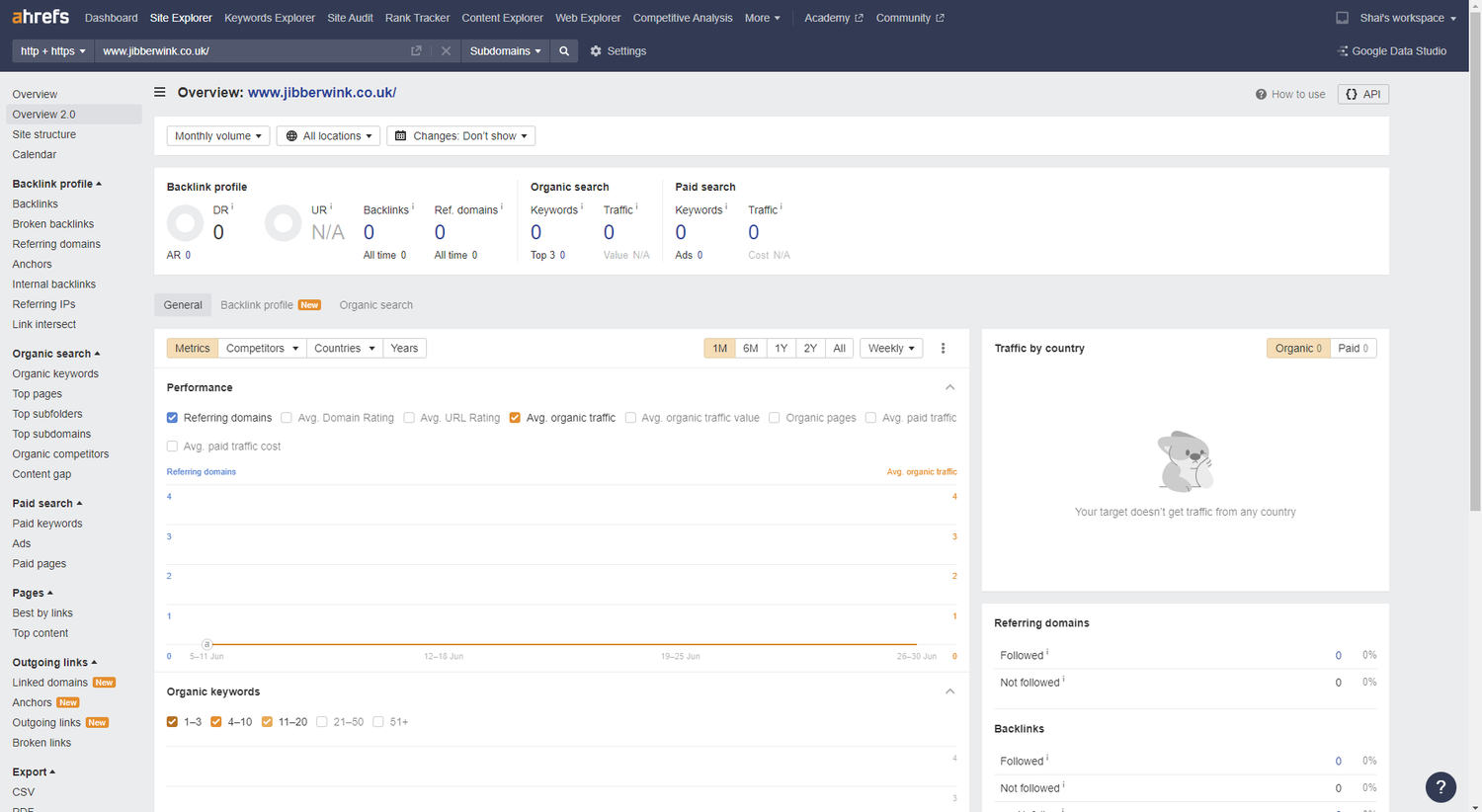

Използвахме също така SEO инструменти на трети страни като ahrefs, Majestic SEO и Semrush, за да потвърдим, че никой от домейните няма външни обратни връзки, сочещи към тях, или исторически класирания в резултатите от търсенето в Google:

Използвахме ahrefs, Majestic и Semrush, за да потвърдим, че нито един от експерименталните ни домейни няма външни обратни връзки, които да сочат към тях.

Анализът по време на експеримента потвърди, че нито един от тестовите уебсайтове не е уловил никакви външни връзки.

И накрая, прегледахме индекса на Google, за да проверим дали не са върнати други резултати, които биха подсказали, че в някакъв предишен момент домейните са били известни на търсачката:

Търсене в Google, което не показва резултати за търсене на един от нашите експериментални домейни.

Всички тези проверки ни позволиха да продължим експеримента, знаейки, че никакви външни и/или исторически сигнали за класиране няма да повлияят на резултатите от теста и да променят класирането на експерименталните домейни.

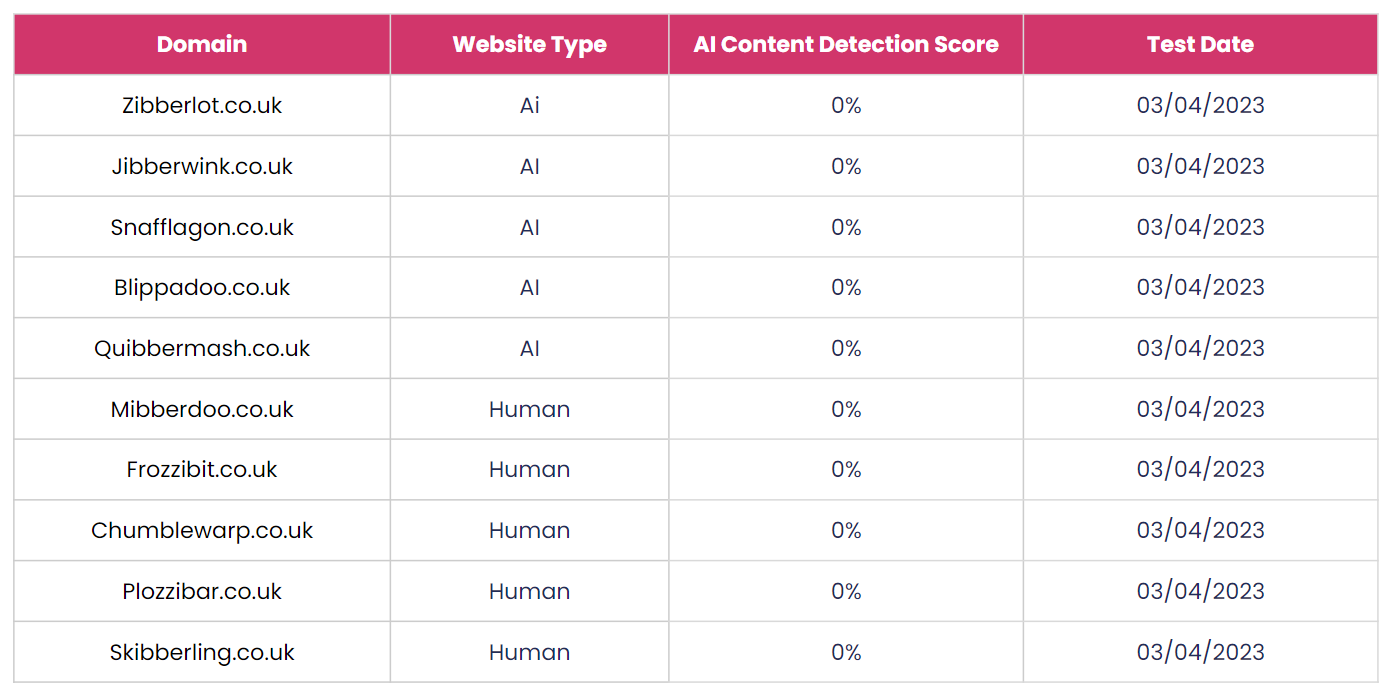

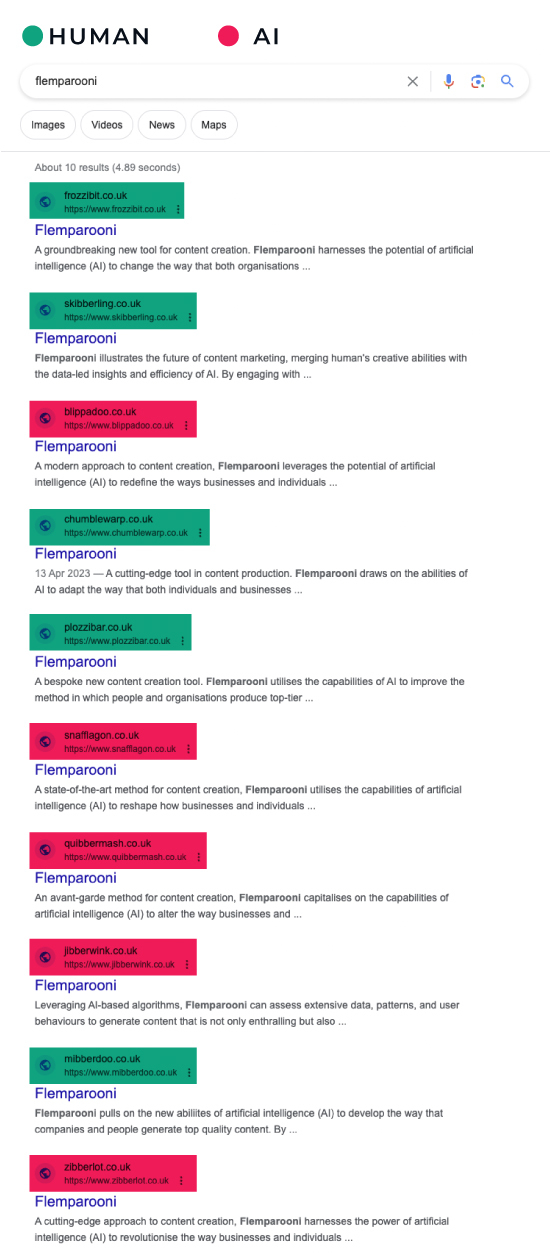

Окончателните тестови домейни:

- Zibberlot.co.uk (AI)

- Jibberwink.co.uk (AI)

- Snafflagon.co.uk (AI)

- Blippadoo.co.uk (AI)

- Quibbermash.co.uk (AI)

- Mibberdoo.co.uk (човек)

- Frozzibit.co.uk (Човек)

- Chumblewarp.co.uk (човек)

- Plozzibar.co.uk (Човек)

- Skibberling.co.uk (човек)

Решихме да проведем нашия експеримент с 10 тестови домейна, 5 от които ще съдържат съдържание с изкуствен интелект и 5 ще използват човешко съдържание.

Създаване на тестово съдържание

Уверихме се, че съдържанието, генерирано от изкуствен интелек, и съдържанието, написано от човек, са еднакво оптимизирани за тестовата ключова дума.

След като бяхме избрали изкуствената ключова дума и тестовите домейни, следващата стъпка беше да създадем съдържание с изкуствен интелект и съдържание, написано от хора, което щеше да бъде публикувано във всеки домейн.

Трябваше да спазваме строги насоки при създаването на съдържанието с изкуствен интелект и на съдържанието, написано от хора, за да сме сигурни, че няма разлики в оптимизацията на уебсайтовете, които да доведат до различно класиране поради промени, несвързани с начина на генериране на съдържанието.

Насоки за създаване на съдържание

По-долу сме изброили някои от насоките, които използвахме, за да гарантираме, че цялото тестово съдържание е еднакво оптимизирано за целевата ключова дума:

- Цялото съдържание трябва да съдържа еднакъв брой споменавания на целевата ключова дума.

- Споменаванията на ключовата дума трябва да се срещат на едно и също място във всяка част от съдържанието.

- Основният смисъл на съдържанието трябва да бъде еднакъв във всеки уебсайт (напр. една част не може да изразява положителни настроения, докато друга изразява отрицателни настроения).

- Всеки уебсайт трябва да съдържа съдържание с приблизително еднаква дължина.

- Всеки уебсайт трябва да съдържа целевата ключова дума на видни позиции, за да бъде оптимизиран за термина за търсене, без да се нарушава втората точка.

- В съдържанието на нито един от уебсайтовете не трябва да се включват вътрешни или външни връзки.

- Нито един от тестовите домейни не трябва да съдържа допълнително съдържание, страници или сигнали за авторитет/доверие (напр. без NAP).

Създадохме съдържанието, генерирано от изкуствен интелект в екипа за SEO, като същевременно работихме в тясно сътрудничество с нашия екип за маркетинг на съдържанието, за да създадем човешкото съдържание. Всяко съдържание беше прегледано спрямо горепосочените насоки, за да се потвърди, че те са еднакви по отношение на оптимизацията на ключовите думи.

Генериране на съдържанието с изкуствен интелект

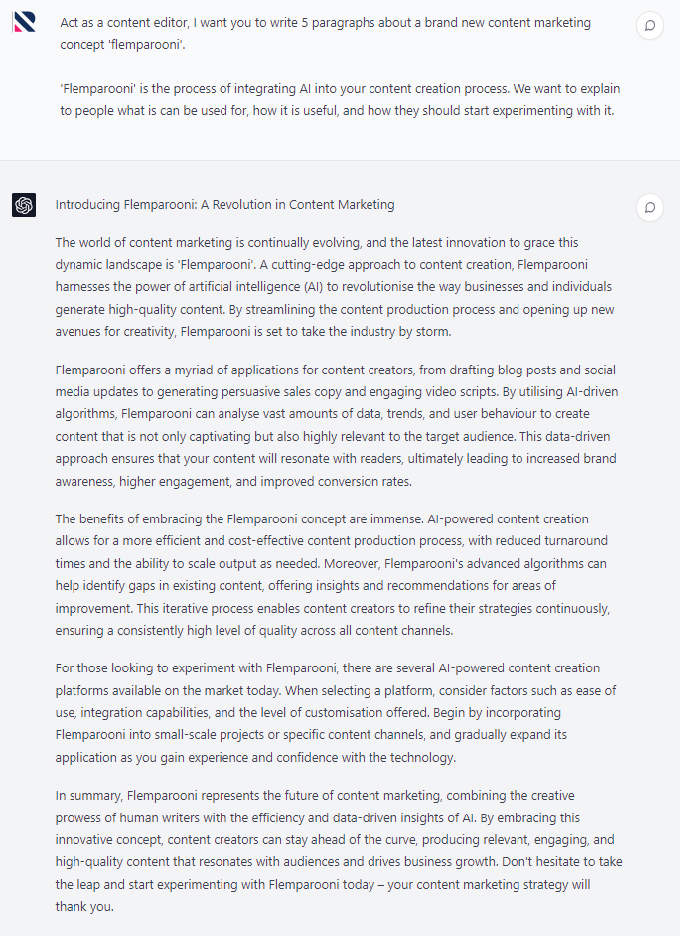

Използвахме ChatGPT, модел GPT-4, за да създадем съдържанието, генерирано от изкуствен интелект.

Първо създадохме промпт, който след това можехме да въведем в ChatGPT, за да генерираме съдържанието с изкуствен интелект, използвано в този експеримент.

Както се очакваше, ChatGPT нямаше проблем да изведе 5 варианта на желаното от нас съдържание и изпълни заявеното със забележителна последователност.

Сходството между съдържанието, генерирано от изкуствен интелект, означаваше, че то остава в рамките на нашите насоки за създаване на съдържание.

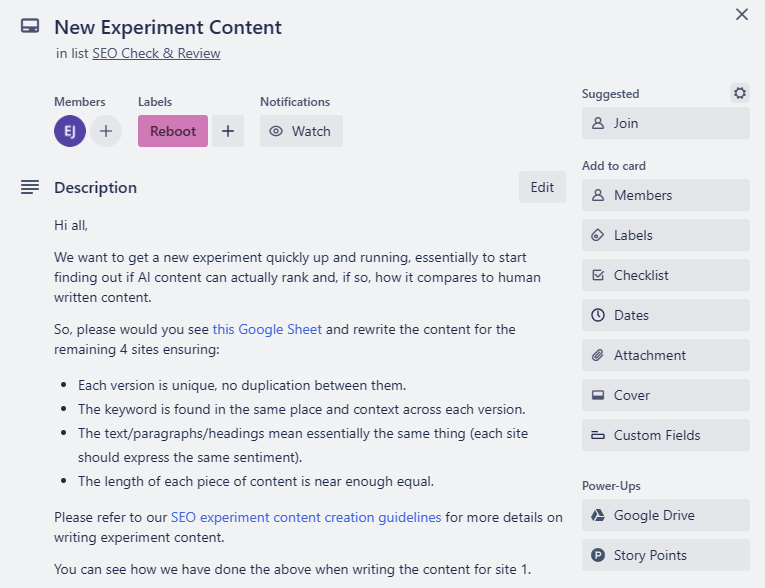

Писане на човешкото съдържание

Предоставихме насоки на нашите автори на съдържание, за да гарантираме, че създаденото от тях съдържание е също толкова оптимизирано за тестовата ключова дума, колкото и генерираното от изкуствен интелект съдържание.

Нашият екип по маркетинг на съдържанието ни е помагал да провеждаме множество SEO експерименти през годините, така че те бяха добре запознати с това как да пишат съдържание, подходящо за този вид експерименти.

Предоставихме кратка информация за създаването на съдържанието, която гарантираше, че създаденото съдържание ще бъде също толкова оптимизирано, колкото и текстът, генериран от изкуствен интелект, но авторите на съдържание не виждаха текста, генериран от изкуствен интелект, преди да напишат съдържанието си.

Екипът се зае с написването на 4-те допълнителни варианта, които ни бяха необходими за нашите тестови сайтове, и в рамките на един ден след заявяването им имахме цялото тестово съдържание, което ни беше необходимо за този експеримент.

Сравняване на съдържанието с изкуствен интелект и човешко съдържание

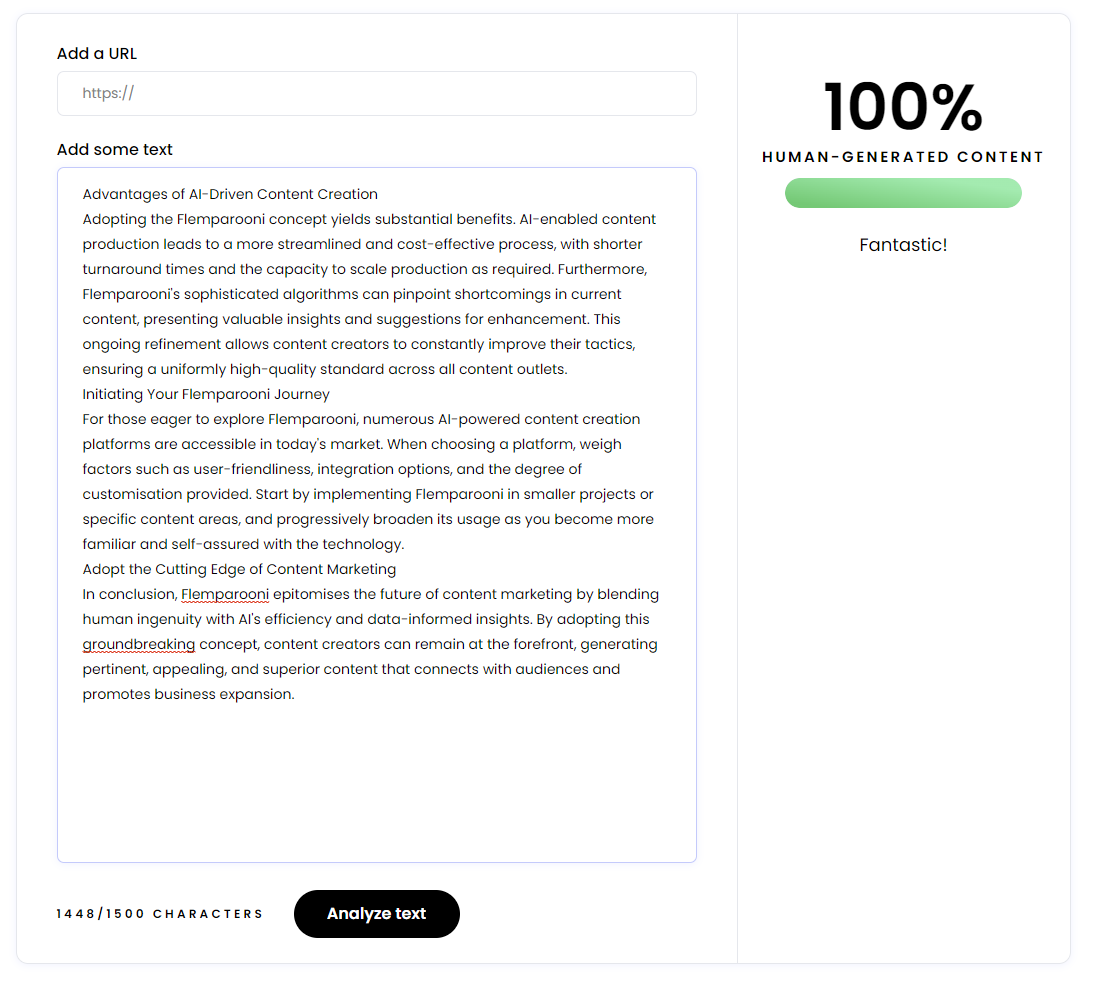

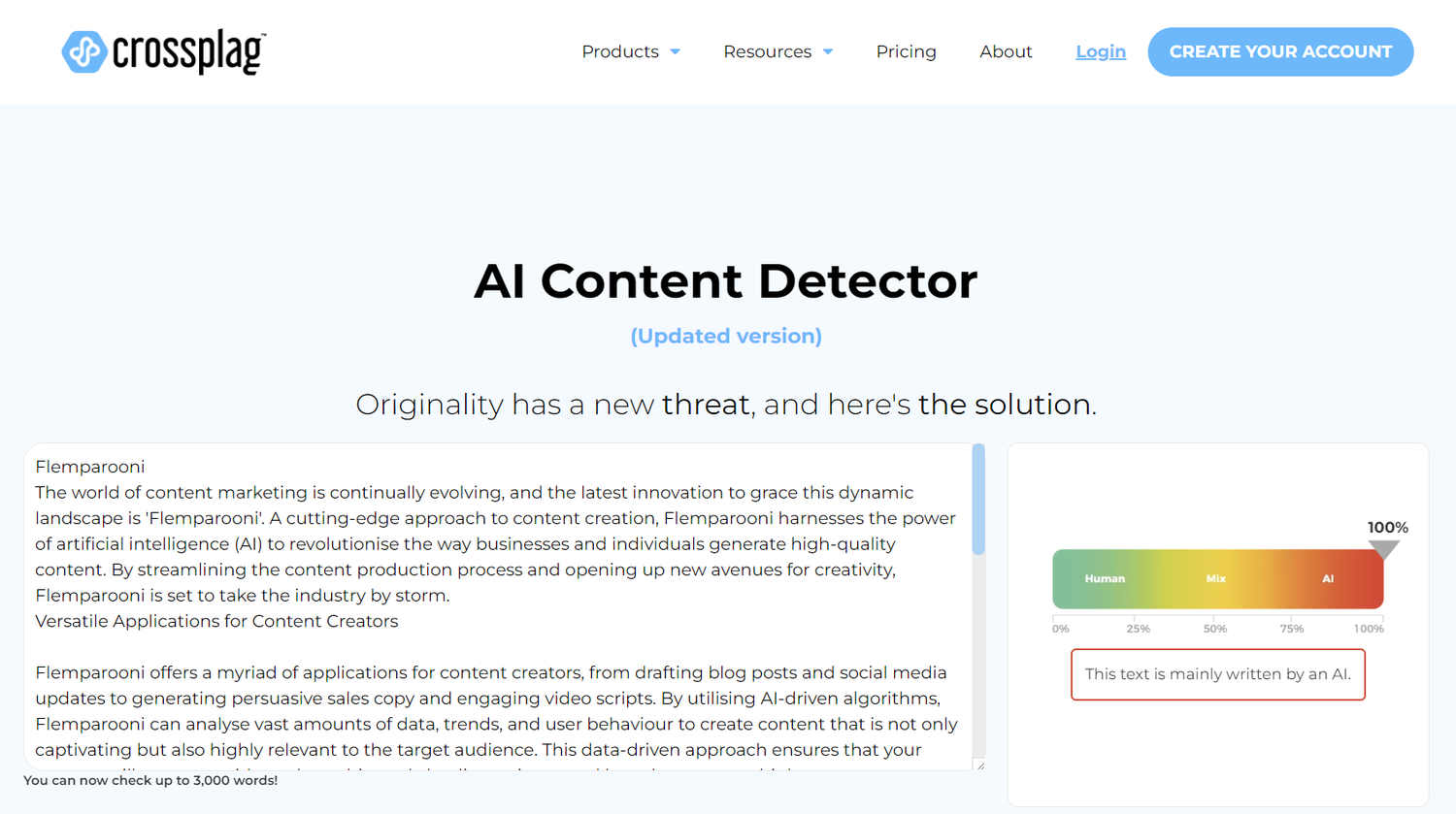

Използвахме инструменти за откриване на съдържание с изкуствен интелект, за да проверим дали наличните по това време инструменти могат да идентифицират нашето съдържание, генерирано от изкуствен интелект (не можаха).

Въпреки че нямаше да разберем дали Google може да направи разлика между нашите тестови сайтове с ИИ и написаните от човек сайтове, докато не бъдат индексирани и класирани, все пак ни беше интересно да разберем колко добри са наличните инструменти за откриване на съдържание с ИИ на трети страни.

Прекарахме цялото съдържание, генерирано от изкуствен интелект и съдържанието, написано от хора, през няколко онлайн инструмента за откриване на съдържание с изкуствен интелект и нито един от тях не идентифицира правилно съдържанието с изкуствен интелект.

Моделът GPT4 беше излязъл скоро и подозирахме, че инструментите за откриване на съдържание все още не са наваксали с най-новия модел.

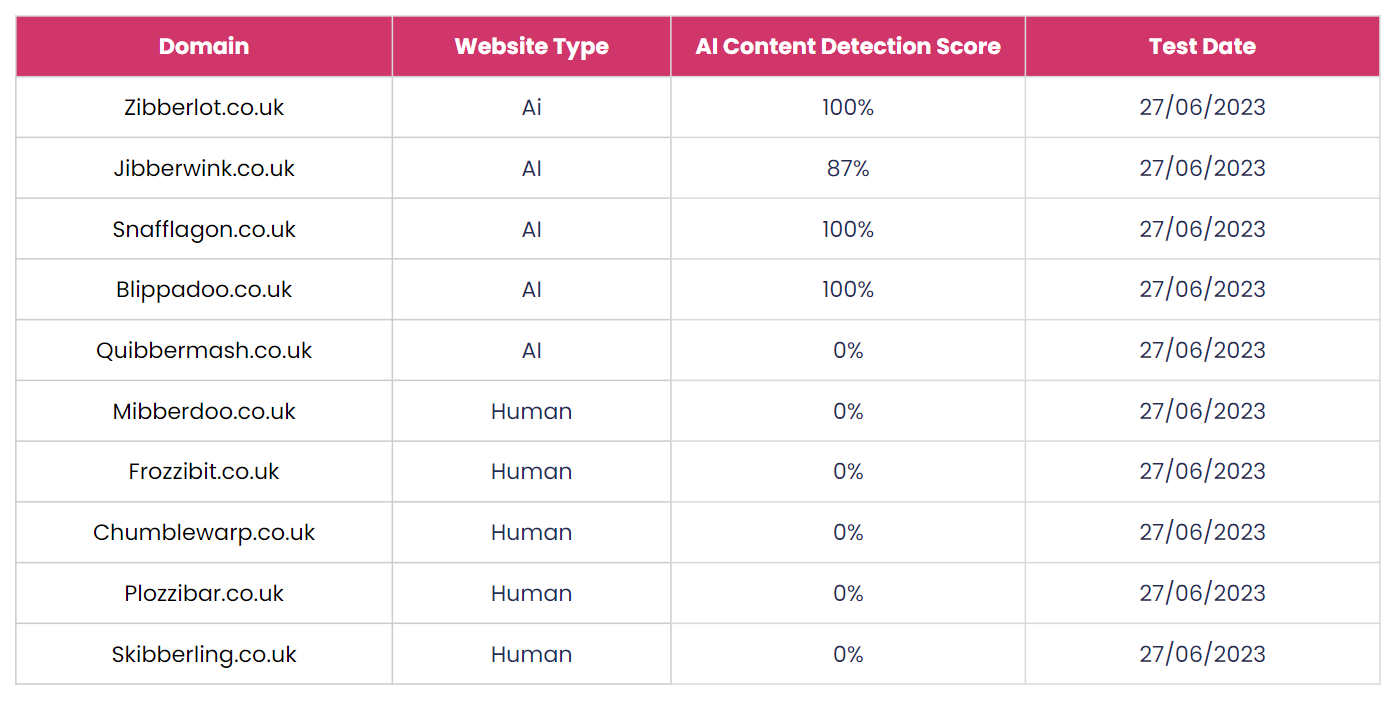

Интересно е, че когато се върнахме и тествахме отново всички уебсайтове, докато пишехме този експеримент, инструментите откриваха съдържанието с изкуствен интелект много по-последователно.

При тестовете ни след експеримента инструментът за откриване на съдържание с изкуствен интелект на Crossplag не успя да открие само един от уебсайтовете със съдържание с изкуствен интелект. Той също така правилно идентифицира всички текстове написани от хора (както беше в началото на експеримента).

Изглежда, че инструментите на трети страни за откриване на съдържание с изкуствен интелект стават много по-добри в идентифицирането на съдържание, което е генерирано от по-усъвършенствани големи езикови модели.

Като се има предвид бързият темп на усъвършенстване на тази технология, чудесно е да се види, че инструментите за откриване също отбелязват такъв силен напредък в рамките на сравнително кратък период от време (3 месеца).

Публикуване на тестовите уебсайтове

След като съдържанието беше готово, следващата стъпка беше да публикуваме тестовите уебсайтове.

Като взехме поука от предишните си експерименти, се уверихме, че всеки от уебсайтовете е публикуван по начин, който не въвежда никакви преки или косвени сигнали за класиране, които биха направили данните ни по-малко надеждни и точни.

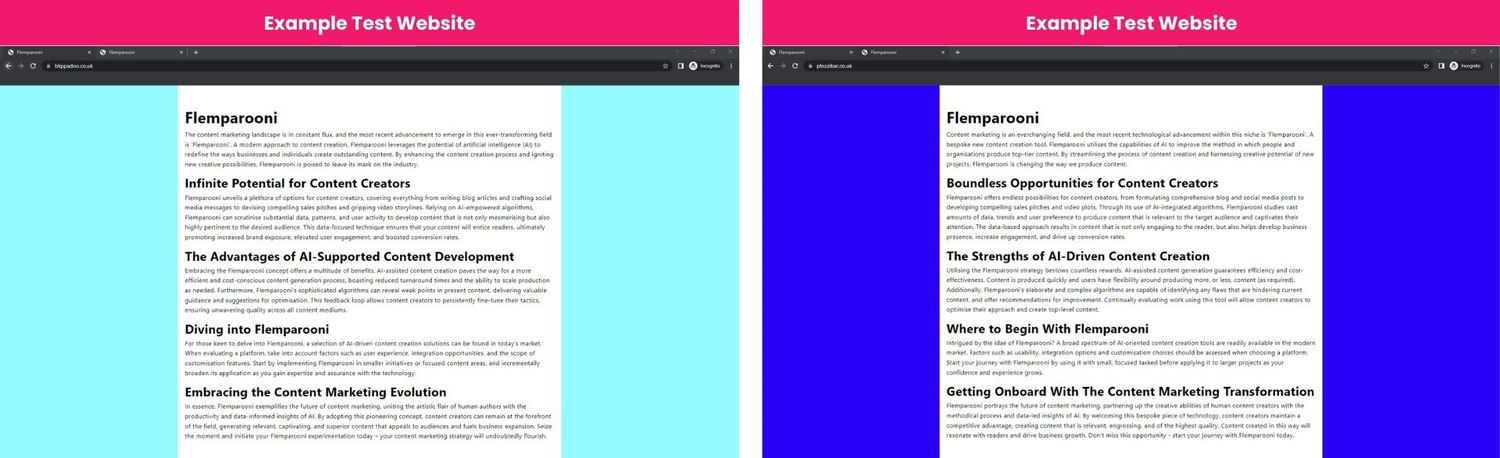

Използвахме прост и сходен HTML шаблон за всеки уебсайт, който изглеждаше почти идентично, само с малки промени в стила (напр. различен шрифт и фон). Шаблоните използваха и уникални имена на CSS класове и ID, така че да не са напълно идентични/точни дубликати.

Всеки домейн беше хостван на AWS само с различен IP от клас C, за да се запазят еднакви резултати за скоростта и производителността на уебсайтовете.

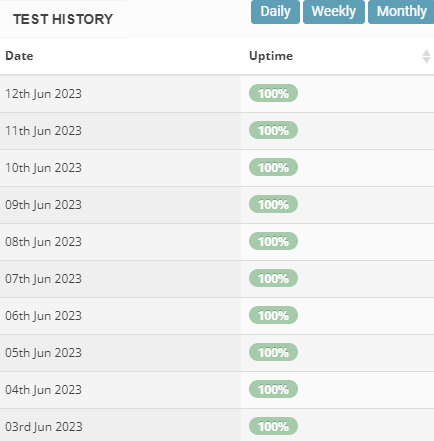

Използвахме StatusCake, за да гарантираме, че скоростта, производителността и времето за работа на тестовите уебсайтове остават еднакви.

Използвахме StatusCake, за да провеждаме почасови тестове за скорост и време на работа в процеса на експеримента, за да гарантираме, че резултатите за скорост и производителност остават еднакви за всички домейни .

Минимизиране на външните фактори за класиране

По-долу сме обобщили начините, по които сведохме до минимум риска от влияние на външни преки и непреки фактори за класиране върху резултатите от нашия тест:

- Свежи имена на домейни без външни обратни връзки, които да сочат към тях.

- Имена на домейни, които никога преди това не са били индексирани/известни на Google.

- На имената на домейни никога не са били хоствани уебсайтове.

- Използване на нова изкуствена ключова дума, за да се сведат до минимум всички фактори, свързани с E-E-A-T.

- Еднакво оптимизирано съдържание на всеки уебсайт.

- Почти идентични HTML и CSS за поддържане на постоянна скорост и производителност на тестовите уебсайтове.

- Стартиране на тестовите уебсайтове в един и същи ден/в рамките на един и същи час, за да се предотврати влиянието на фактори, свързани с „възрастта“, върху резултатите.

- Часови проверки на скоростта и времето за работа, за да се гарантира, че скоростта/производителността са еднакви.

- Една и съща хостинг конфигурация за всеки уебсайт (всички са хоствани на една и съща инстанция на AWS и използват Cloudflare).

- Никакви търсения на ключовата дума през целия период на теста (използвахме външни инструменти за проследяване на ранга).

- Никой извън нашата компания не знаеше за тестовите домейни и не ги посещаваше през целия период на експеримента.

Възможността да се сведе до минимум влиянието на фактори за класиране извън нашата независима променлива по този начин е това, което прави тези контролирани експерименти толкова трудни за провеждане, но също така е това, което прави техните резултати възможно най-точни.

Проследяване и отчитане на класирането

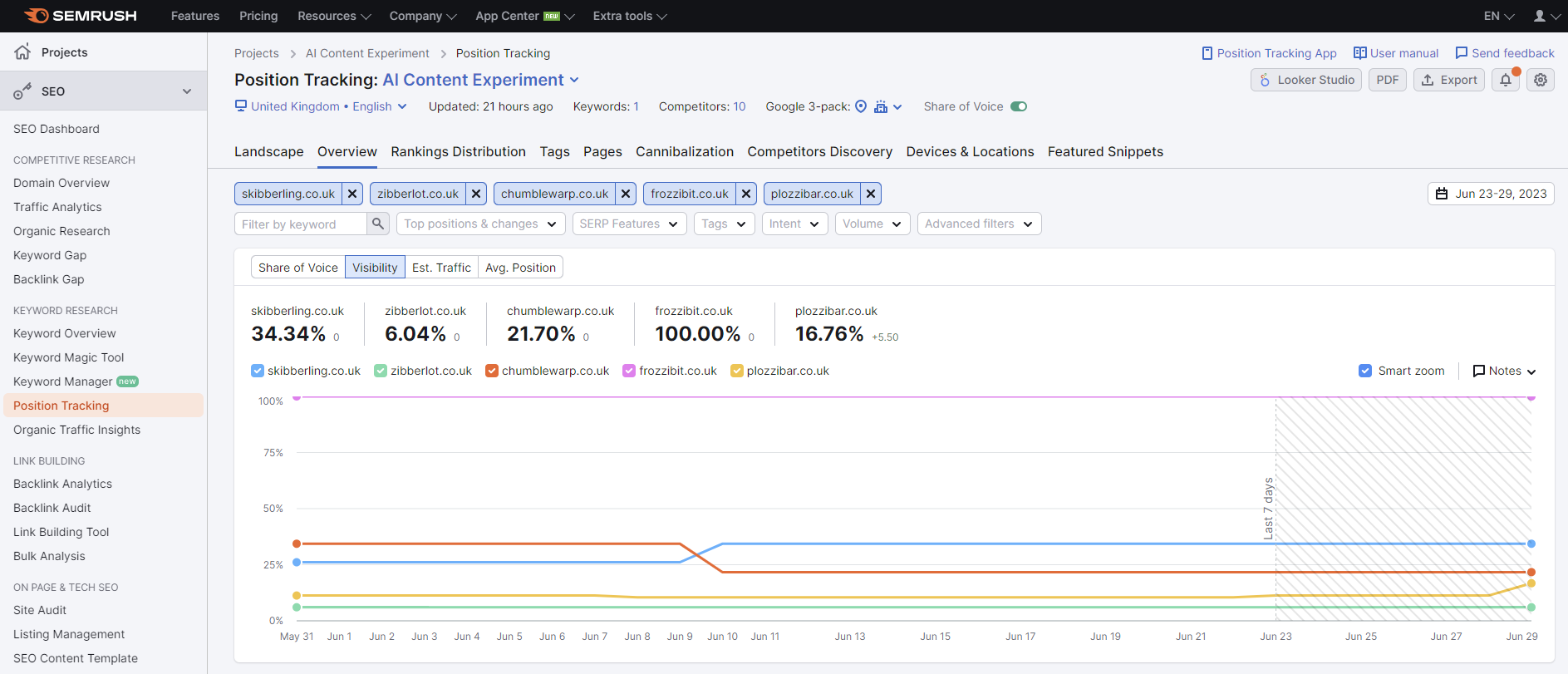

Използвахме Semrush за проследяване на класирането на нашите тестови уебсайтове.

За да избегнем въвеждането на каквото и да е потенциално влияние от сигналите за ангажираност със SERP за нашата изкуствена ключова дума, се уверихме, че никой не е търсил тестовата ключова дума в хода на експеримента.

Използвахме Semrush, за да проследим класирането на тестовите ни сайтове и се позовахме на тези данни при анализа на резултатите.

Всички тестови уебсайтове бяха проследявани в рамките на една кампания за проследяване на позициите в Semrush, като по този начин се гарантира, че класиранията се актуализират по едно и също време и че никакви фактори, свързани с локализацията и/или персонализацията, няма да повлияят на данните.

Проследяването на позициите се извършваше веднъж на ден за времето на експеримента.

Резултати

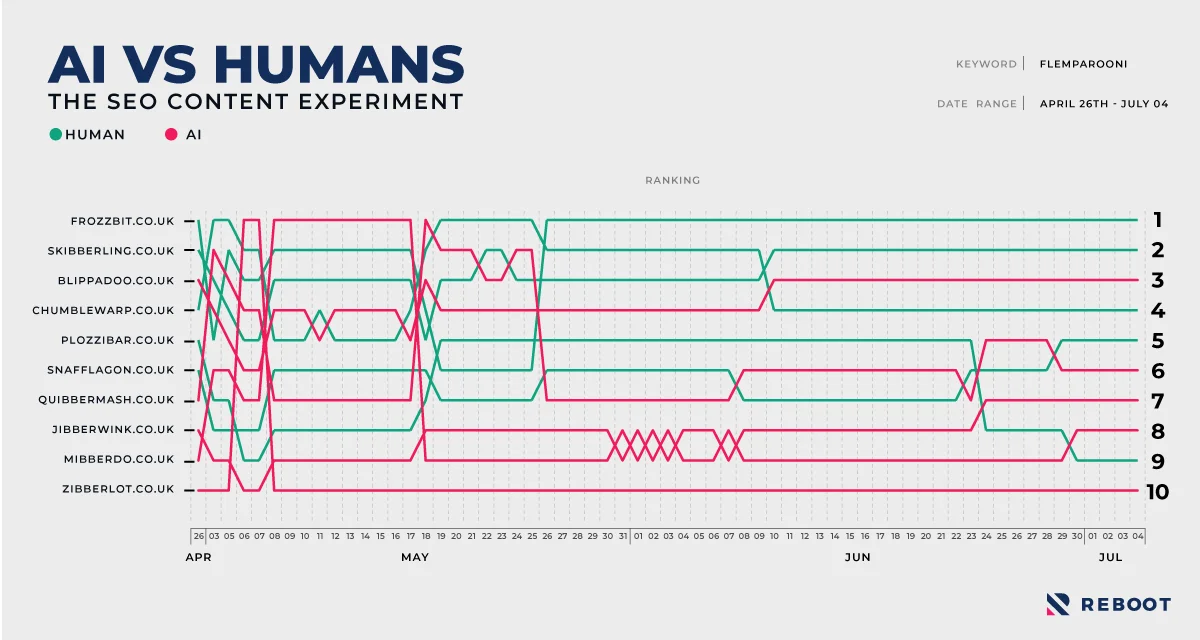

Съставихме и интерактивна версия на графиката за проследяване на позиции по-долу:

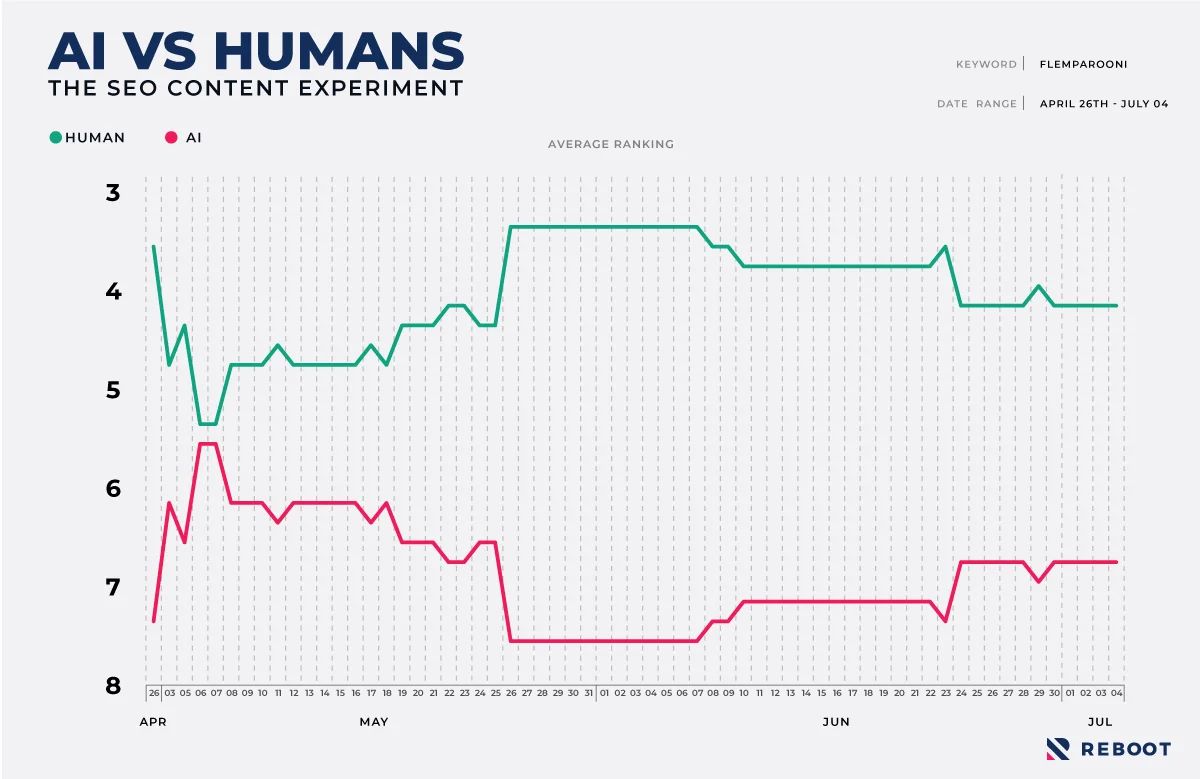

Данните от проследяването на ранга ясно показват, че написаното от хора съдържание се класира по-добре от съдържанието, генерирано от изкуствен интелект.

Ако разгледаме данните от момента, в който всички тестови уебсайтове са се класирали за целевата ключова дума и нататък, домейните, генерирани от изкуствен интелект, имат средно класиране от 6,6, докато домейните написани от човек имат средно класиране от 4,4.

Беше много интересно да се види, че домейните с написано от човека съдържание изпреварват домейните с генерирано от изкуствен интелект съдържание, след което трябваше да разберем дали резултатите са статистически значими.

Статистическа значимост

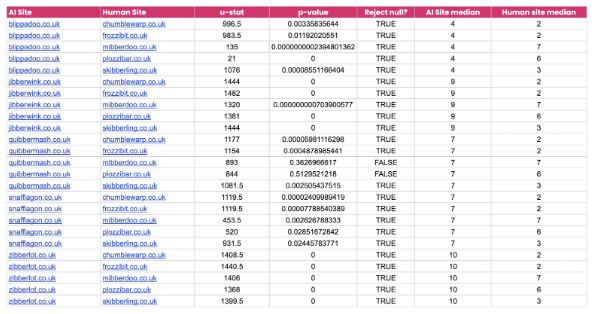

Помолихме нашия екип да прегледа резултатите и да провери дали са статистически значими. Те решиха да проведат Mann Whitney U тест, който щеше да покаже дали единият вид уебсайт (домейните с човешко съдържание) има тенденция да постига по-добри класирания от другия вид уебсайт (домейните със съдържание, генерирано от изкуствен интелект).

Ето какво каза анализаторът на данни Джейк Тийг:

„Нулевата хипотеза“ за този тест е, че чрез произволно подбиране на стойности от две популации (в този случай SERP връзки за сайтове с изкуствен интелект или човешки сайтове), вероятността X да е по-висока от Y е същата като вероятността Y да е по-висока от X. Накратко, това по същество е тест на медианите в рамките на всяка популация, за да се измери дали те са еднакви или са различни. В този случай популацията е класирането на този уебсайт във времето, където по-ниска стойност означава по-високо класиране.

Тестът на Ман Уитни U връща U-статистика, която показва колко различни са средните стойности на двете популации една от друга. По-голямата U-статистика показва, че сайтът с изкуствен интелект се класира по-ниско от човешкия сайт, докато по-малката U-статистика (по-близка до 0) показва, че сайтът с изкуствен интелект има по-висок общ рейтинг от човешкия.

За 5 сайта с изкуствен интелект и 5 сайта с човешки интелект беше тествана всяка двойка сайтове с изкуствен интелект/човешки интелект, общо 25 теста. Стойностите на всяка популация бяха измерени от точката, в която бяха генерирани ранговете (така че стойности от 0 бяха изключени).

При всички проведени тестове в 92 % от случаите беше отхвърлена нулевата хипотеза. По същество това означава, че е налице статистически значима разлика между медианите на ранговете за уебсайтовете с изкуствен интелект и човешките уебсайтове.

По-нататъшното проучване на резултатите показва, че от 25-те двойки 1 уебсайт с изкуствен интелект (Blippadoo.co.uk) е надминал 2 човешки уебсайта. Също така, при 2 други теста не успяхме да отхвърлим нулевата хипотеза, която предполага, че медианите на популациите на уебсайтовете с изкуствен интелект и на човешките уебсайтове са еднакви/сходни. Въпреки това при останалите 21 теста човешките уебсайтове се представиха по-добре от тези с изкуствен интелект. Това показа, че по-малката медиана (и следователно по-високият ранг) води до по-голям U-stat във всички случаи.“.

Дискусия

Експериментът ясно показа, че съдържанието, генерирано от ИИ, се класира по-слабо (средно) от съдържанието, генерирано от човек.

Очакваме с нетърпение да чуем от SEO общността техните мнения за това как Google може да е успяла да идентифицира съдържанието, генерирано от изкуствен интелект и да го вземе предвид при класирането си.

Знаем, че големите езикови модели, които обсъждахме, включват (но не са непременно ограничени до) предсказване на следваща дума, което предполага, че алгоритъмът би могъл да определи математически какъв текст е генериран по този начин спрямо съдържание, което не е генерирано.

Последици

От всички експерименти в областта на SEO оптимизацията този има може би най-големи последици в краткосрочен план за собствениците на уебсайтове, авторите на съдържание и агенциите за SEO оптимизация.

От една страна, данните предполагат, че създателите на съдържание не трябва да се притесняват, че генерираният от изкуствен интелект спам скоро ще ги изпревари по мащаб. От друга страна обаче, тази мощна нова технология неизбежно ще доведе до промени в резултатите от търсенето и ежедневната работа, извършвана от SEO специалистите.

Вече виждаме, че търсачки като Bing и Google вграждат генериращ изкуствен интелект в своите резултати от търсенето и може би не след дълго тези, които управляват целия си органичен трафик чрез публикуване на общи информационни статии, ще се окажат в конкуренция със самите търсачки.

Ограничения

Важно е да се обсъдят ограниченията на всяко проучване и ние искахме да се възползваме от тази възможност, за да обсъдим някои от ограниченията, които наблюдавахме по време на провеждането на експеримента. По-долу сме коментирали някои от ограниченията, които установихме при изготвянето на нашата методология и констатации.

Изкуствени ключови думи

Първото нещо, което трябва да отбележим, е, че използвахме изкуствена ключова дума за проучването, което някои може да сметнат за ограничение.

Изкуствените ключови думи ни позволяват да премахнем въздействието на фактори за класиране извън нашата независима променлива и са един от малкото начини да припишем какъвто и да е ефект на причинно-следствена връзка на SEO към независима променлива.

Естествено обаче използването на изкуствена ключова дума въвежда аргумента, че ще има и други фактори, когато става въпрос за класиране на реални уебсайтове в действителната страница с резултати от търсенето. Трябва да имаме предвид, че точно това е целта на тези експерименти – да отстраним от уравнението всякакви външни влияния върху класирането ,да стесним фокуса си и да установим дали нашата независима променлива има някакво силно въздействие върху класирането на експерименталните домейни.

Неизбежно трябва да имаме предвид всичко гореизложено, когато обвързваме резултатите от експеримента с реалните резултати от търсенето на действителните уебсайтове.

Възможно е някои домейни със съдържание с изкуствен интелект да се класират добре в резултат на други фактори на сайта и извън него или на начина, по който се използва изкуственият интелект, но въпреки това при равни други условия данните показват, че съдържанието написано от хора, има тенденция да се представя по-добре от съдържанието генерирано от изкуствен интелект (засега).

Размер на извадката

Друго ограничение е размерът на извадката, използвана за това проучване.

Провеждането на подобни контролирани експерименти е много трудоемко, изисква много енергия и ресурси, а работата с по-голяма извадка от тестови уебсайтове неизбежно изисква изразходването на значително повече време и средства за продължителен период .

Въпреки това, като се има предвид строгата настройка на средата на този експеримент, ние сме уверени, че от нашата малка извадка от тестови домейни могат да се извлекат някои ключови прозрения.

Промени в изкуствения интелект

За времето, през което провеждаме този експеримент, в областта на изкуствения интелект е постигнат значителен напредък.

Google все по-ясно заявява собствените си амбиции да използва съдържание, генерирано от изкуствен интелект в резултатите от търсенето, а частни компании непрекъснато публикуват нови модели и модели с отворен код.

Можем да видим това в начина, по който инструментите за откриване на съдържание с изкуствен интелект се усъвършенстваха в хода на експеримента, като сега могат да откриват съдържание, генерирано от GPT-4, много по-надеждно, отколкото когато започнахме теста.

Възможно е за известно време Google да се опитва да открие и управлява потока от съдържание, генерирано от изкуствен интелект, което вероятно ще бъде публикувано онлайн през следващите години. Трябва да признаем и факта, че Google отдавна е лидер в тази област и има голяма вероятност вече да е доста напред в сравнение с това, което другите създават в това пространство.

Редактиране на съдържанието

Този експеримент не разгледа как редактирането и усъвършенстването от човек на съдържанието, генерирано от изкуствен интелект може да повлияе на класирането, а вече активно се работи по обучението на моделите да пишат със същия тон на гласа, формат и стил като обучаващия ги бизнес, което вероятно също ще повлияе на това колко уникално е генерираното съдържание.

Възможно е квалифициран автор на съдържание да редактира и персонализира съдържанието, генерирано от ИИ, да даде по-добри дългосрочни резултати и да направи съдържанието на ИИ съобразено с предпочитания тон и стил на марката ви.

Искахме да изкажем особено голяма благодарност на Сайръс Шепърд от Zyppy SEO, който се съгласи да наблюдава този експеримент (и някои от предишните ни).

Тези експерименти нямаше да са възможни и без помощта на нашите екипи по маркетинг на съдържанието, данни, графики, уеб разработчици и разбира се на нашите управляващи директори Наоми и Шай Ахарони, които ни позволяват да полагаме толкова големи усилия в тестването на широко разпространени SEO теории, митове и погрешни схващания.

Заключителни мисли

Бързото развитие на изкуствения интелект, което се наблюдава през последните месеци, предизвика много дебати, дискусии и дори тревога сред агенциите.

За съжаление не е необичайно да се чете за закриването на някога големи екипи за съдържание, тъй като фирмите се стремят да спестят пари, като възлагат създаването на съдържание на инструменти с ИИ.

Един от основните изводи от този експеримент е, че съдържанието написано от квалифицирани автори, посветени на създаването на съдържание, което резонира и се свързва с целевата им аудитория, все още е много търсено (от читателите и от търсачките).

В заключение бихме искали да добавим, че ще продължим да гарантираме, че нашето съдържание е не само най-доброто, но и човешко.

Референции, източници и използвани инструменти

- https://writer.com/ai-content-detector/

- https://copyleaks.com/ai-content-detector

- https://crossplag.com/ai-content-detector/

- https://contentdetector.ai/

- https://www.zerogpt.com/

- https://openai.com/

- https://www.semrush.com/

- https://ahrefs.com/

- https://archive.org/

- https://majestic.com/

- https://www.google.co.uk/

- https://www.statuscake.com/

- https://www.rebootonline.com/blog/ai-vs-humans-content-writing-seo-experiment/